科技圈顶级大佬,为何都在关注核电?

为啥各科技大佬们纷纷

把目光投向了核能发电?

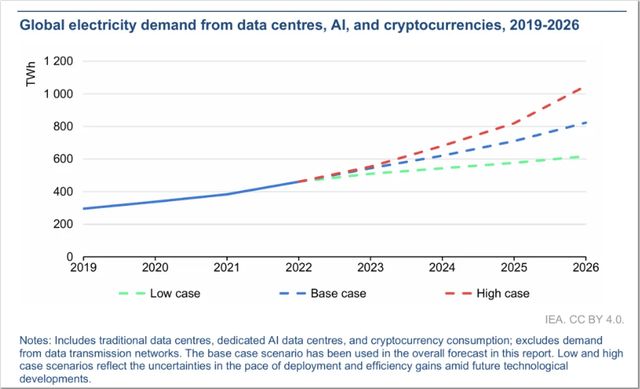

近年来随着AI这个“吞电巨兽”的快速成长,数据中心的用电需求逐渐令人难以置信。据国际能源署(IEA)近期公布的一篇报告显示,到2026年,全球数据中心的电力需求将从2022年的460TWh增至800TWh,几乎翻了一番。

面对日益严峻的电力挑战,更高效、可控、可扩展的核能发电自然成为了“大佬优选”。

能源密度与效率

核能具有极高的能源密度。这意味着使用核能可以实现“用更少的燃料产生更多的电力”。如1公斤的铀-235通过核裂变可产生大约2.4百万千瓦时的能量,远远超过同质量的煤、天然气或其他可再生能源。

稳定性与可控性

核能在稳定性和可控性方面有着明显优势。核电站可以提供24/7的基载电力,无论天气如何,都能保持稳定的连续发电。这种连续性是电网平衡和稳定的关键,尤其是对于电力需求波动较大的地区。并且相比风能、太阳能,核能发电输出更具可控性,不受自然条件的限制更减少了部署大规模储能系统的成本。

可扩展性

核电站的规模可以灵活调整。从小型模块化反应堆(SMR)到大型核电厂,均能满足不同地区和需求的电力供应。

小型模块化反应堆(SMR)是先进的核反应堆,其功率容量高达每台300兆瓦(电),约为传统核动力反应堆发电容量的三分之一。基于占地面积小、可预先制造后运输到现场安装、相对低成本、更具安全性等优势,SMR被设想用于工业应用或电网容量有限的偏远地区等市场。

不过,尽管各国及国际组织正积极进行大量研发工作,并推进其实际应用、商业化部署进程,但因面临着诸多技术、材料、工程、经济和社会层面的挑战,截至目前,仍未有真正意义上的商用核聚变发电厂投入运营。

特别是技术方面。因实现核聚变反应需要达到极端条件,核聚变技术的发展在很大程度上依赖于计算能力的进步。如等离子体的精确模拟、反应堆设计与优化、中子辐射对材料的影响模拟、以及实时控制系统的开发等,都需要超级计算机提供强大的算力支持。

丰富的超算经验

助力核聚变发展

在HPC领域深耕多年的戴尔有着丰富的超算支持经验。如为美国麻省理工学院林肯实验室超级计算中心(LLSC)计算集群、Eni公司的HPC5、加拿大西蒙弗雷泽大学的Cedar(GPU)集群等提供超算系统支持,与英国剑桥大学联合打造英国首个百万兆次级的超级计算机Dawn等。

其中,Dawn便是通过和人工智能技术结合,在高度沉浸、互联的虚拟环境中对核聚变发电厂的物理和工程问题进行建模,为英国“于2040年运行全球首个商用核聚变发电厂”的STEP计划提供了助力。

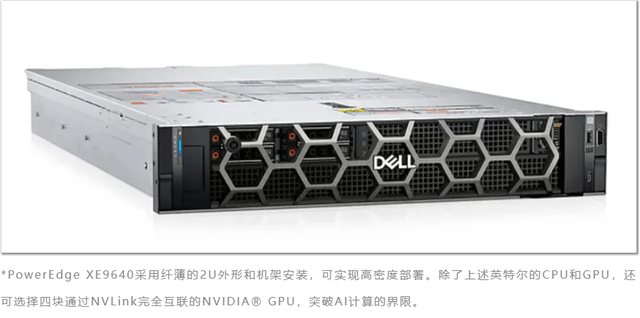

Dawn的服务器堆栈主要由戴尔PowerEdge XE9640构成,内置超过一千个GPU(英特尔®数据中心GPU Max系列)和超过500个CPU(英特尔®志强®处理器),能够将复杂问题分解为并行任务、快速地处理巨量数据,满足需要处理大量变量与参数(如模拟多种反应堆配置、燃料循环、冷却系统等)的数字孪生技术极高的算力需求。

并且,PowerEdge XE9640具备多达32个DDR5内存DIMM插槽、4个PCle Gen5插槽和8个驱动器,能够轻松满足超算高可扩展性需求,助力核聚变发电厂进行更复杂、更高精度的系统仿真与优化。

此外,戴尔经验证的PowerScale HPC存储解决方案,也可为快速数据增长、各种工作负载对吞吐量和容量的更高需求提供管理。通过采用OneFS操作系统,PowerScale可降低复杂性并优化数据密集型HPC工作负载的性能,为用户提供可扩展的HPC存储,简化采用和管理,使HPC系统能够提供变革性的决策、业务增长和运营效率。

结 语

今年,STEP计划取得了重要进展——整个计划的三分之一已于3月完成,并将过渡到第二阶段。随着超算、AI等技术的进步,以及核聚变发电商业化的推进,能源危机与环境问题预计会有很大改善。戴尔科技将继续通过不断的技术创新,加速这一进程,为实现更加清洁、安全、可持续的未来贡献力量。

<< 上一篇

下一篇 >>

网友留言(0 条)